动图轻松理解 Self-Attention (自注意力机制)

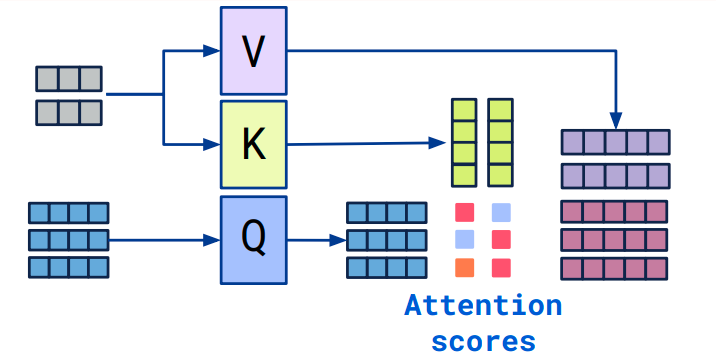

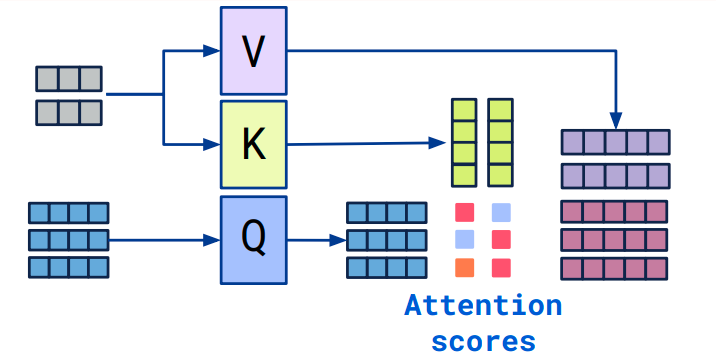

Self-Attention 是 Transformer 中最核心的思想。我们在阅读 Transformer 论文的过程中,最难理解的可能就是自注意力机制实现的过程和繁杂的公式。

Self-Attention 是 Transformer 中最核心的思想。我们在阅读 Transformer 论文的过程中,最难理解的可能就是自注意力机制实现的过程和繁杂的公式。

在 ChatGPT 计算处理完之后,也需要将结果再做逆转换,形成文字形式,反馈给用户。这种转换包括两个步骤,Tokenizer 和 Embedding。本节主要介绍这两个模块。

OpenAI 的 GPT 系列模型,包括其它科技公司研发的各种最先进的 NLP 模型,甚至图像处理模型,广泛采用了 Attention 注意力机制进行建模,它可谓是当前 NLP 神经网络的灵魂机制。