AI Infra 与 Infra

近些年来,关于 AI Infra 和传统 Infra 之间的差异引发了广泛讨论。一些工程师认为,AI Infra 与他们熟悉的传统 Infra 相距甚远,尤其是面对 GPU、KVCache、3D 并行等新概念时,难免感到困惑和不安。究竟 AI Infra 真的与传统 Infra 有着天壤之别,还是说它们之间其实是某种延续与演变?

近些年来,关于 AI Infra 和传统 Infra 之间的差异引发了广泛讨论。一些工程师认为,AI Infra 与他们熟悉的传统 Infra 相距甚远,尤其是面对 GPU、KVCache、3D 并行等新概念时,难免感到困惑和不安。究竟 AI Infra 真的与传统 Infra 有着天壤之别,还是说它们之间其实是某种延续与演变?

AI Infra 是连接算力和应用的 AI 中间层基础设施,涵盖了数据准备、模型训练、模型部署和应用整合等环节,其中的基础软件工具有较高商业化潜力;目前 AI Infra 产业处于高速增长的发展早期,未来几年内各细分赛道有望保持 30%+ 高速增长。

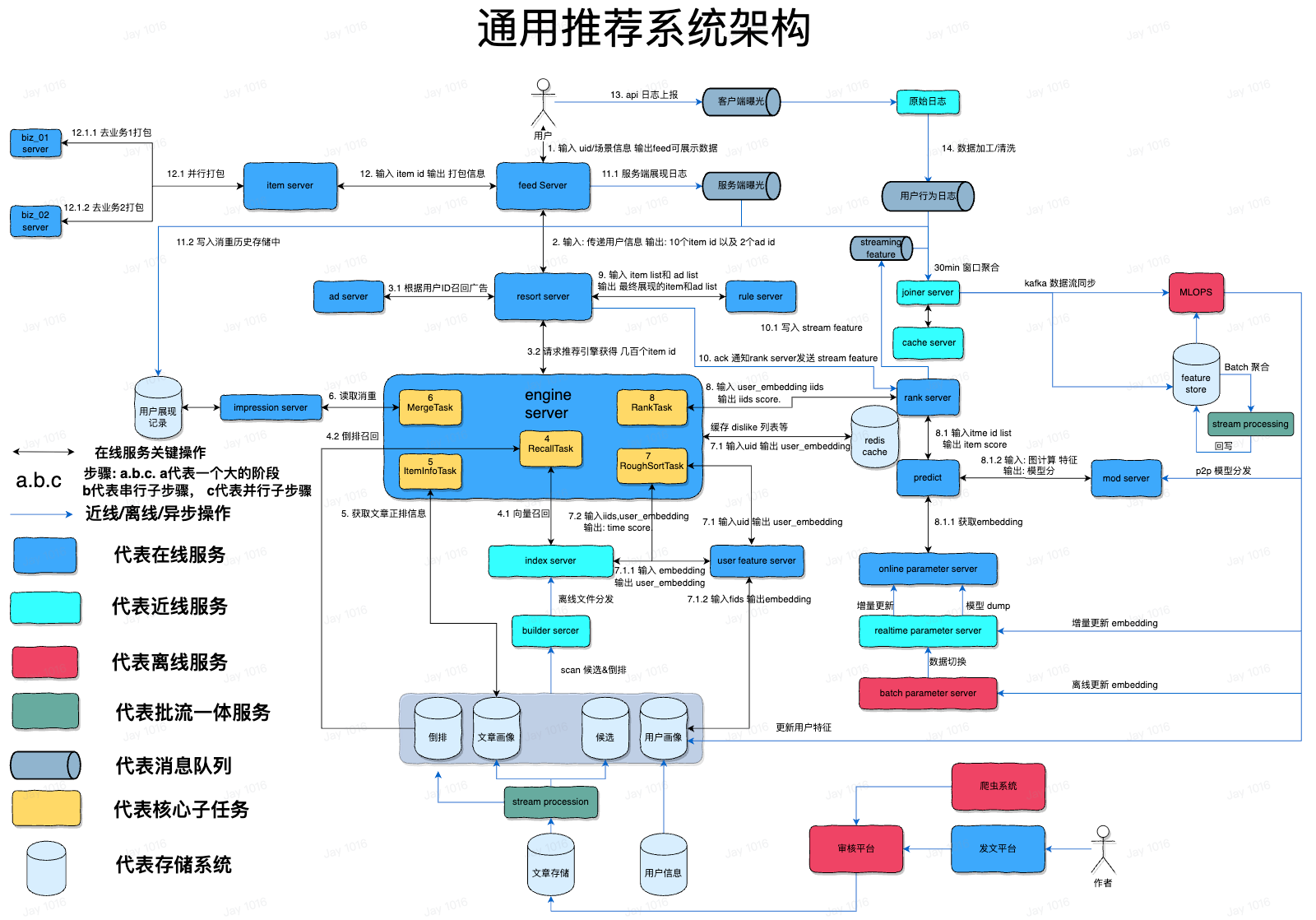

随着互联网上的信息越来越多,人们陷入了选择困难,人们在阅读信息之前,可能对信息一无所知,只有看到时才知道是否喜欢,人们越来越懒,这就催生出了推荐系统:基于用户广泛的历史行为,预测用户可能感兴趣的信息主动推送,从而达到用户与信息的匹配,由于用户在推荐之前并不知道内容是什么,这扩大了信息的候选范围,进一步提高了潜在的广告位数量,这成为互联网应用的核心竞争力,这是技术与业务的完美结合。

在 ChatGPT 计算处理完之后,也需要将结果再做逆转换,形成文字形式,反馈给用户。这种转换包括 Tokenizer 和 Embedding,本文要介绍这两个模块。

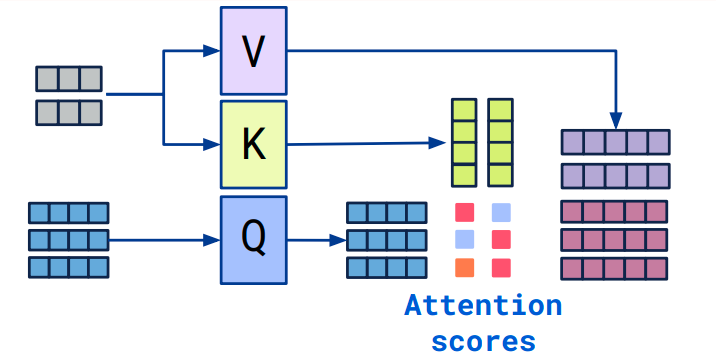

Self-Attention 是 Transformer 中最核心的思想,我们在阅读 Transformer 论文的过程中,最难理解的可能就是自注意力机制实现的过程和繁杂的公式。

OpenAI 的 GPT 系列模型,包括其它科技公司研发的各种最先进的 NLP 模型,甚至图像处理模型,广泛采用了 Attention 注意力机制进行建模,它可谓是当前 NLP 神经网络的灵魂机制。